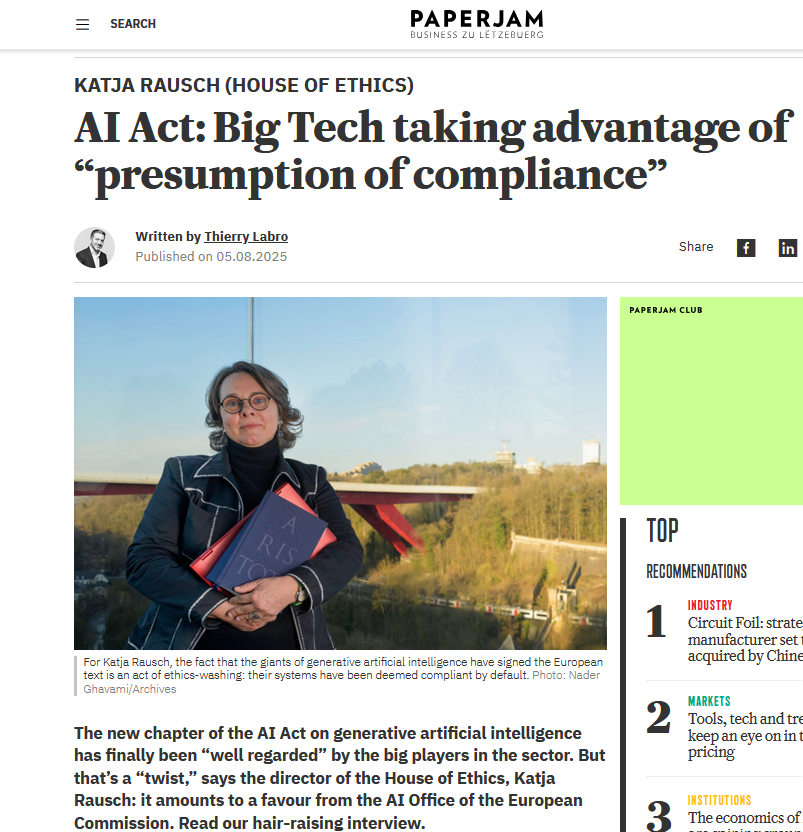

Spécialisée dans l’éthique des nouvelles technologies, Katja Rausch travaille sur les décisions éthiques appliquées aux domaines tels l’intelligence artificielle, la data éthique, les interfaces machine-homme, la roboéthique ou la Business éthique.

Pendant 12 ans, Katja Rausch a enseigné les Systèmes d’Information au Master 2 de Logistique, Marketing & Distribution à la Sorbonne et pendant 4 ans les Data Ethics au Master de Data Analytics à la Paris School of Business.

Diplômée de la Sorbonne, Katja Rausch est linguiste et spécialiste en littérature du 19ème siècle. Partie à la Nouvelle-Orléans aux États-Unis, elle a intégré la A.B. Freeman School of Business pour un MBA en leadership et enseigné à Tulane University. À New York, elle travaille pendant 4 ans pour Booz Allen & Hamilton, management consulting. De retour en Europe, elle devient directrice stratégique pour une SSII à Paris où elle conseille, entre autres, Cartier, Nestlé France, Lafuma et Intermarché.

Auteure de 6 livres dont un dernier en novembre 2019, Serendipity ou Algorithme (2019, Karà éditions). Elle apprécie par-dessus tout les personnes polies, intelligentes et drôles.